#13. Search Central Live NYC 2025 : points clés

Nouveautés dans la Search Console, AI Overviews, Google Actualités, Contenu IA, Pénalités - tout ce qu'on apprend depuis le dernier Search Central Live de Google.

Salut, c’est Alexis 👋

Bienvenue à 111(❤️🔥) nouveaux abonnés depuis la dernière édition ! Si vous n’êtes pas encore abonné, il n’y a rien de plus simple ⬇️

Merci également à Lionel et Arnaud qui ont pris des abonnements payants à la newsletter! Ce n’est pas obligatoire, mais, je ne vais pas le cacher : ça me motive bien à préparer pour vous des sujets exclusifs et utiles 😉

Cette newsletter devait partir encore vendredi dernier, mais les voies anti-spam de Gmail sont impénétrables et malgré toutes mes investigations et tous mes efforts, il est possible que vous voyiez un message rouge au dessus de ce texte.

N’hésitez pas à le marquer comme “Le message semble sûr“. Je vous promets, il n’y a rien de suspect ni malveillant dans mes envois. Merci ! 😉

Search Central Live NYC 2025

Search Central Live est une série d'événements proposée par l'équipe de Google Search Central.

La dernière édition s’est déroulée le 20 mars à New York et a abordé une large palette de sujets autour des nouveautés dans la recherche, des outils de Google, la position du moteur vis-à-vis des sujets sensibles et populaires.

Je vous propose une synthèse sous forme de bullet points des informations les plus importantes qui ont été annoncées, rappelées ou démenties.

Ces éléments ont été recueillis à travers des tweets, des photos, des discussions et des articles partagés par les confrères présents sur place.

N.B. Je me suis permis d’omettre certains propos de type “Merci, Capitaine Obvious”, mais j’en ai gardé tout de mème quelques-uns pour une couverture plus complète de l’évènement.

Bonne lecture!

Evolution de l’écosystème du Search

Les résultats de recherche évoluent et évolueront toujours. Voici comment Google voit cette évolution :

Google cherche à proposer une variété de moyens complémentaires pour que les utilisateurs puissent rechercher au-delà du mot-clé traditionnel :

Langage naturel

Images via Lens

Commandes vocales

Recherche multimodale

Activation des conversations de suivi

Les Guidelines de Google pour Quality Raters montrent où Google va, ce qu’il pense et considère comme “de qualité”.

L'IA ne remplacera pas toute la recherche. De nombreux éléments fondamentaux de la recherche resteront, même avec des réponses générées par l'IA.

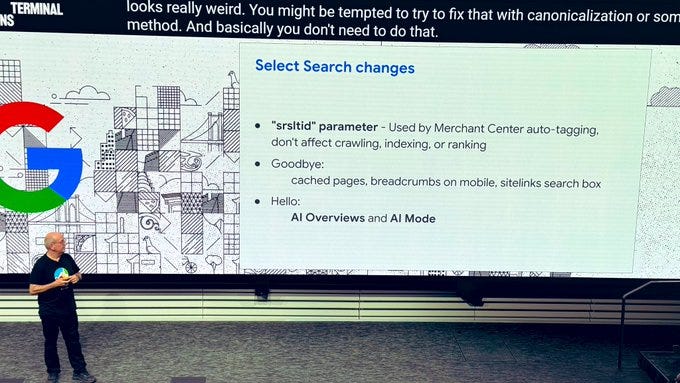

Nouveautés et disparitions :

Un certain nombre de fonctionnalités ont été abandonnées récemment par Google, d’autres ont rejoint l’écosystème du moteur.

Paramètre "srsltid" utilisé par l'auto-étiquetage de Merchant Center :

Selon Google, n'affecte pas le crawl, l'indexation ou le classement.

Selon Google, nombreux ont été ceux qui ont commencé à mettre en place les rel canonical, mais en fait c’était pas nécessaire de le faire.

On a récemment dit adieu à:

Google Cache.

Fils d'Ariane (breadcrumbs) sur mobile.

SiteLinks Search Box.

On dit bonjour à :

AI Overviews

AI Mode

Google Search Console

Bientôt, l'API de Google Search Console affichera les données horaires des 8 derniers jours.

Dans la Search Console, le fuseau horaire est toujours celui de Californie dans tous les rapports, sauf celui sur 24 heures. Donc, on ajoute 8 heures pour avoir l’heure française. Dans GA4, vous pouvez configurer votre propre fuseau horaire.

La Search Console comptabilise toutes les impressions, positions, clics, dont ceux provenant des résultats AIO (AI Overviews).

Les clics et impressions issus des résultats AI sont inclus dans le filtre “Web” de la Search Console (de la même manière que ceux issus des Featured snippets (“position 0”), Top stories etc.)

À ce jour, il n'est pas prévu d'ajouter une option permettant de filtrer l'audience provenant uniquement des AI Overviews dans la Search Console.

La principale raison en est que l'équipe de GSC s'inquiète de l'« actionnabilité » (c'est-à-dire de l'utilité concrète) de cette séparation d'indicateurs. Chez Google, on attend que la fonctionnalité (AI Overviews) soit plus stable et plus mature. Dans le futur : « Oui », mais pas pour l'instant.

Google rappelle que la position dans la Search Console dépend de la position du bloc. Quand les AI Overviews apparaissent sur vos mots-clés, et vous n’êtes pas cité dedans, votre position moyenne dans la Search Console baisse.

Google Actualités

Google a rappelé qu’il utilisait 7 groupes de signaux pour classer les sites dans Google Actualités: Pertinence, Localisation, Proéminence, Autorité, Fraîcheur, Utilisabilité et Intérêts.

Crédit photo : Lily Ray.

Ce n’est pas une nouveauté, car c’est exactement ce qui est décrit sur la page officielle de Google intitulée “Understanding How News Work in Google”.

Un bon rappel que les paywalls ne font pas dégrader le groupe de signaux autour l’utilisabilité. Mais ça, on l’a également dans la documentation officielle:

E-E-A-T

John Mueller a essayé d’expliquer une nouvelle fois en mots simples ce que Google entendait par les 4 composantes du concept E-E-A-T :

La qualité d'une page correspond à la manière dont elle atteint son objectif.

Lors de l'évaluation de la qualité d'une page, Google prend en compte E-E-A-T :

Expérience : l'expérience directe du créateur.

Expertise : le degré de connaissance ou de compétence nécessaire du créateur de contenu sur le sujet.

Autorité : le degré auquel le créateur de contenu ou le site web est reconnu comme une source de référence ou une autorité sur le sujet (ex. l'OMS pour le COVID).

Fiabilité : le degré auquel la page est précise, honnête, sûre et fiable.

Google définit l'EEAT, mais précise que “vous ne pouvez pas simplement saupoudrer de l'EEAT sur votre site. Cela ne fonctionne pas comme ça”.

AIO (AI Overviews)

L’intégration de l’IA dans la recherche de Google a résonné en fil rouge à travers toutes les keynotes.

La position de Google est claire : présenter toutes les nouveautés de la recherche sous un jour positif.

Mais les réponses aux questions importantes soulèvent plus d’interrogations qu’elles n’apportent de réponses.

Par exemple, une question essentielle : si les AI Overviews génèrent plus de trafic vers un plus grand nombre de sites, pourquoi ne pas fournir un mécanisme officiel pour suivre cette audience ? Espérons que ce ne soit qu’une question de temps.

Propos retenus:

Plus d'1 milliard de personnes utilisent AIO dans le monde.

Google observe que les résultats AIO amènent les utilisateurs à poser davantage de questions différentes et les font visiter une plus grande diversité de sites (répétition de ce communiqué de presse).

Les premiers retours pour Google sont extrêmement positifs avec un taux de satisfaction élevé, notamment chez les utilisateurs âgés de 18 à 24 ans.

Inspiré du succès de Discover, Google continuera à fournir aux utilisateurs des idées, des réponses rapides et de l'inspiration en fonction de leurs intérêts et préférences.

AI Overview locaux : Les AI Overviews locaux restent L’intégration des données de Google Business Profile n’est pas prévue dans les AI Overviews.

Pas de clarté non plus sur un mécanisme officiel de tracking du trafic issu des AIO :

Daniel Waisberg dit que les paramètres UTM ne sont pas une solution suffisante et qu'ils ne veulent pas favoriser leur propre produit (GA4).

La grande majorité des fonctionnalités dans GSC ne peuvent pas être séparées, cependant ils vont prendre en compte ce retour car il est "constant" dans les messages reçus.

💡 Comment configurer GA4 pour suivre les visites depuis AI Overview ? (Inconvénient: on compte aussi ceux des positions 0 et People Also Ask)Voix humaine à l’ère de l’IA

Le cœur de la recherche reste l'information fiable.

Les utilisateurs veulent un mélange de sources, de types de contenu et d'expériences.

Dans la todo de Google de mettre en avant le vrai contenu humain :

Perspectives authentiques

Vidéos UGC (contenu généré par les utilisateurs)

Accès aux forums et discussions

Personnalisation.

Google peut améliorer la pertinence et l'identification en affichant un mélange de sources et de types de contenus tels que “authentic human voices“ ("voix humaines authentiques") et des "forums et discussions".

Google s’apprête à inclure le contexte de l'auteur (comme son titre, grade etc.) et les « voix diverses » comme étiquettes dans le carrousel « Perspectives » pour les résultats d'actualités.

Liens dans les AI Overviews : résumés prédictifs et ancrage

John Mueller et Danny Sullivan ont apporté des éclaircissements sur le mécanisme de citation dans les AI Overviews qui fonctionne différemment que celui de SearchGPT.

Et c’est probablement la partie la plus intéressante de tout l’évènement 🙂

Notamment pourquoi les pages citées dans les résultats IA sont différentes de celles positionnées dans Google sur la requête saisie.

Dans la citation de sources, Google utilise 2 mécanismes :

Résumés prédictifs (“predictive summaries”).

Ancrage (“grounding”).

J’essaye d’expliquer les 2 concepts de manière claire et simple.

Résumés prédictifs

Quand l’IA de Google génère une réponse, elle cherche non seulement à répondre à la requête elle-même, mais également à anticiper d’autres requêtes connexes que l’internaute ferait après sa recherche initiale, pour aller plus loin.

La réponse finale générée par l’IA contient donc à la fois la réponse à :

la requête saisie directement par l’internaute.

ces requêtes connexes.

Google appelle cette réponse “predictive summary” ou un résumé prédictif.

Ainsi, dans les citations on retrouve les sources qui ne sont pas directement et étroitement liées à votre requête précise.

Ancrage

L’ancrage (ou “grounding” en anglais) c’est un autre mécanisme de Google, rien à voir avec le premier.

Dans le cas du SEO classique, Google part d’une page web pour ensuite utiliser son contenu.

Dans le cas de l’IA, Google génère une réponse (AI Overviews) à partir des informations dont il dispose. Une fois que la réponse est prête, il va la revérifier en cherchant la source la plus appropriée dans son index de recherche.

Cette opération permet à Google de lutter contre les hallucinations propres à l’IA (une sorte de fact-checking en place) et de citer les sources.

💡 En savoir plus sur l'ancrage dans Gemini et Google.Les 2 mécanismes en place font de sorte que les liens dans les AI Overviews peuvent ne pas correspondent aux TOP pages dans la recherche organique classique.

Quelle est l’attitude de Google par rapport aux contenus générés par l’IA ?

Globalement pas de nouveautés sur l’attitude de Google envers le contenu généré par les LLMs.

En même temps, il ne faut pas voir la vie en rose. Même si la position officielle du moteur de recherche est : "Peu importe qui a rédigé le contenu, l’essentiel est qu’il soit utile", Google apprend délibérément à distinguer si un contenu a été écrit par un humain ou une intelligence artificielle. Pour le bon fonctionnement de son écosystème de recherche, il doit le savoir.

Quelques propos de la keynote:

Les évaluateurs de la qualité chez Google sont chargés de repérer les contenus générés par l'IA (présentant peu ou pas d'effort ou d'originalité) et de les étiqueter avec la note de qualité la plus basse.

Sur ce point, les speakers ont renvoyé vers le point 4.6.6 des Guidelines pour Quality Raters:

Il est obligatoire pour Google Shopping que les images générées par l'IA soient correctement étiquetées.

Les images générées par l'IA doivent être étiquetées à l'aide d'une balise méta liée aux métadonnées de l'image :

L'utilisation de l'IA générative seule ne signifie pas une violation pour la production de contenu en masse.

Il y a des cas d’usage de l’IA toute à fait corrects et appréciés, par exemple, faire le résumé d’une multitude d’avis de produits sur Amazon.

Toute méthode de génération massive de contenu doit être examinée avec soin :

Est-ce principalement pour générer du trafic de recherche ?

Est-ce non original ?

Apporte-t-il une réelle valeur unique aux visiteurs ?

Abus de réputation d’un site

50% des documents que Google trouve sur le web ouvert sont du spam.

Cependant, Google est fier que 99% des résultats de recherche sont exempts de spam.

Les dernières vagues de pénalités (qui ont fait et continuent de faire du bruit) portaient sur l’utilisation abusive de la réputation d’un site.

Pour rappel, l'utilisation abusive de la réputation d'un site consiste à publier du contenu externe sur celui-ci pour manipuler les résultats de recherche en profitant de sa notoriété.

Le simple fait d'avoir du contenu tiers ne constitue pas une violation de la politique de Google. De nombreux sites possèdent du contenu tiers, ce qui peut être logique et attendu. La page des politiques anti-spam fournit des exemples.

Le contenu provenant de freelances n'est pas en soi une violation. Google n'a pas de liste de freelances qu'il pénalise 🙄.

Pour qu'un contenu soit considéré comme une violation de politique, et attirer des pénalités liées à l’abus de l’autorité, deux éléments doivent être réunis :

Contenu tiers : Il s'agit de contenus créés par des entités externes au site hôte, comme les utilisateurs, les freelances ou les services en marque blanche. Ces contenus proviennent de personnes non employées directement par le site hôte.

Exploitation des signaux de classement : Cela se produit lorsqu’un site publie du contenu externe pour profiter de sa propre notoriété dans les résultats de recherche. Cette pratique devient abusive si l’objectif est uniquement d’améliorer le classement du contenu externe plutôt que de créer un site indépendant.

Toutes les sanctions pour l’abus d’autorité d’un site sont à ce jour manuelles (c’est bien d’avoir cette confirmation que les pénalités ne sont pas algorithmiques).

Si l'outil de désaveu n'est plus disponible, comment supprimer les backlinks toxiques ?

Lors d’une séance de Q&A cette question récurrente a été posée.

Les réponses de John Mueller restent sans changement:

Google n'a pas de notion de "backlinks toxiques" en interne.

Pour la plupart des cas, "nous essayons d'ignorer ces liens".

"N'utilisez l'outil de désaveu que lorsque vous recevez une pénalité manuelle pour des liens, SI vous achetez des liens. Ce n'est pas un outil à utiliser régulièrement."

Google favorise-t-il les grands éditeurs au détriment des petites sources de contenu ?

Danny Sullivan a exprimé sa volonté d'aider davantage les petits sites indépendants à réussir.

Réflexion en cours chez Google pour renforcer la visibilité des créateurs de contenu indépendants.

"Nous avons fait des choses pour aider [les petits éditeurs]", “mais il est peu probable qu'il y ait une mise à jour spécifique axée sur les sites indépendants”. Ces améliorations sont plutôt intégrées aux mises à jour globales de l'algorithme.

Les systèmes de Google n’ont pas de label “grande marque“.

Les grandes marques bénéficient d’une meilleure visibilité organique, car il y a d’autres signaux positifs qui vont avec : mentions fréquentes, recherches récurrentes etc.

Google a reçu environ 13 000 retours d'expérience l'année dernière.

Un problème récurrent est que les internautes arrivent sur des sites sans savoir ce qu'ils vont y trouver.

L'important est que les visiteurs comprennent rapidement le contenu du site après leur arrivée depuis une recherche.

Google souhaite que les contenus soient clairs, pertinents et utiles pour les lecteurs.

Merci d’avoir lu jusqu’à la fin, j’espère vous avez trouvé des choses utiles!

C’est tout pour aujourd’hui et je vous dit à très vite !

Si vous avez des questions, des remarques ou simplement envie de laisser un petit mot, n'hésitez pas, je lis tout et je réponds à chacun :)