#4. Google Leak : hype ou opportunité ?

Comprendre, analyser & interpréter la fuite de Google

Salut, c’est Alexis! 👋

Il était difficile d'imaginer un sujet pouvant reléguer au second plan le lancement de AI Overview aux États-Unis, mais c'est arrivé : la fuite de la documentation de Google Content API Warehouse la semaine dernière a fait, et continue de faire, beaucoup de bruit dans les milieux SEO du monde entier.

La fuite de données a engendré, comme il se doit, deux extrêmes dans la manière de la percevoir : un scepticisme total ou presque (on ne croit pas / on savait tout cela / ce n’est pas le vrai code / ce n’est pas à jour, etc.) ou au contraire l’effet de la balle en argent (“maintenant, nous allons tout découvrir”).

Alors, comment s’y prendre ? Est-ce une perte de temps ou une opportunité inédite ?

Voici mon avis personnel qui n’engage que moi :)

TL;DR

Personnellement, on est sur quelque d’exceptionnel qui n’est jamais arrivé dans notre métier. Je reste positif et très curieux par rapport aux documents dévoilés à la fois pour mes tests SEO et l’activité de R&D.

Même si cette fuite ne révolutionne pas notre métier tout de suite, elle va certainement avoir des débouchés dans le développement d’outils SEO, métriques à suivre et analyser, contribuer à l’ouverture d’esprit de ce que le moteur peut considérer comme signaux de classement.

Juste attention à la bonne interprétation et surtout au temps qu’on peut passer dessus🧐

Factuel :

Le 13 mai 2024 des milliers de documents internes ont été publiés accidentellement sur le GitHub de Google Content API Warehouse.

Le 28 mai 2024 cette fuite est devenue publique, mettant en évidence 2 569 documents listant 14 014 attributs, principalement autour des différents aspects du fonctionnement du moteur de recherche.

La base de données contient plusieurs versions, dont celle sous le numéro 0.40 qui est la plus complète. Il y a aussi une version plus récente - 0.50, mais qui est beaucoup plus restreinte.

La fuite a été confirmée par Google.

La dernière date mentionnée (une fois) dans les documents est août 2023 et il est raisonnable de la garder en tête pour l’actualité de l’information.

L’ensemble des documents en question est disponibles sur ce lien.

Comprendre la nature des données dévoilées

Pour pouvoir interpréter les données, il est important de comprendre ce qu’elles sont.

La documentation mentionne différentes équipes de Google: Hotels team, Ads team, Visual Shopping Team, Google Shopping Express Team, Geo Schema team, SAFT Team, GT Team, Routines team, TTS team, Paint Team, quality teams etc.

Pour que tout cette horde d’experts divers et variés puisse travailler efficacement (ne pas faire le même travail 2 fois, bénéficier de l’expertise d’autres équipes), ils se sont créé des référentiels d’attributs communs accessibles via l’API.

Derrière chaque attribut - une opération spécifique.

Par exemple, si l'équipe de Google Shopping souhaite ajouter une fonctionnalité de compression des images, elle peut rechercher dans ce référentiel pour vérifier si une autre équipe ne l'a pas déjà développée.

L’objet de cette fuite, c’est justement un de ces référentiels : Google Content API Warehouse.

Cette base de données contient une longue liste d’attributs organisée et standardisée pour être facilement utilisable par toutes les équipes d’ingénieurs de Google.

Mais au delà des noms d’attributs et d’explications concises, nous n’en savons plus rien: nous ne pouvons regarder dans le code derrière, nous ignorons les particularités d’usage, ni l’importance dans l’algorithme de classement.

Même si les attributs présents semblent traiter de la recherche d'information et du fonctionnement de moteurs de recherche, de quel moteur de recherche s'agit-il : la recherche web, les produits dans Google Shopping, les mails dans Gmail ? Il est possible qu'il s'agisse un peu de tous.

Cette fuite ressemble fort à celle de Yandex en début de l’année 2023 quand on a également eu accès à une immensité de facteurs de classement (nom utilisé dans la documentation) avec un peu plus d’explications, mais toujours sans pondération.

Et la pondération c’est tout dans le SEO.

Comment interpréter les informations dévoilées ?

Objectivement, on peut comprendre le sens de chaque attribut :

sur son nom, souvent accès explicite.

sur les courtes descriptions qui accompagnent les noms d’une grande partie d’attributs.

sur le type de la donnée (valeur continue, booléenne (oui/non) etc.)

sur certains marqueurs comme par exemple “DEPRECATED” (“déprécié”).

C'est tout ce que nous savons, et toute interprétation au-delà de ces informations est subjective et, dans les cas extrêmes, tend à la spéculation.

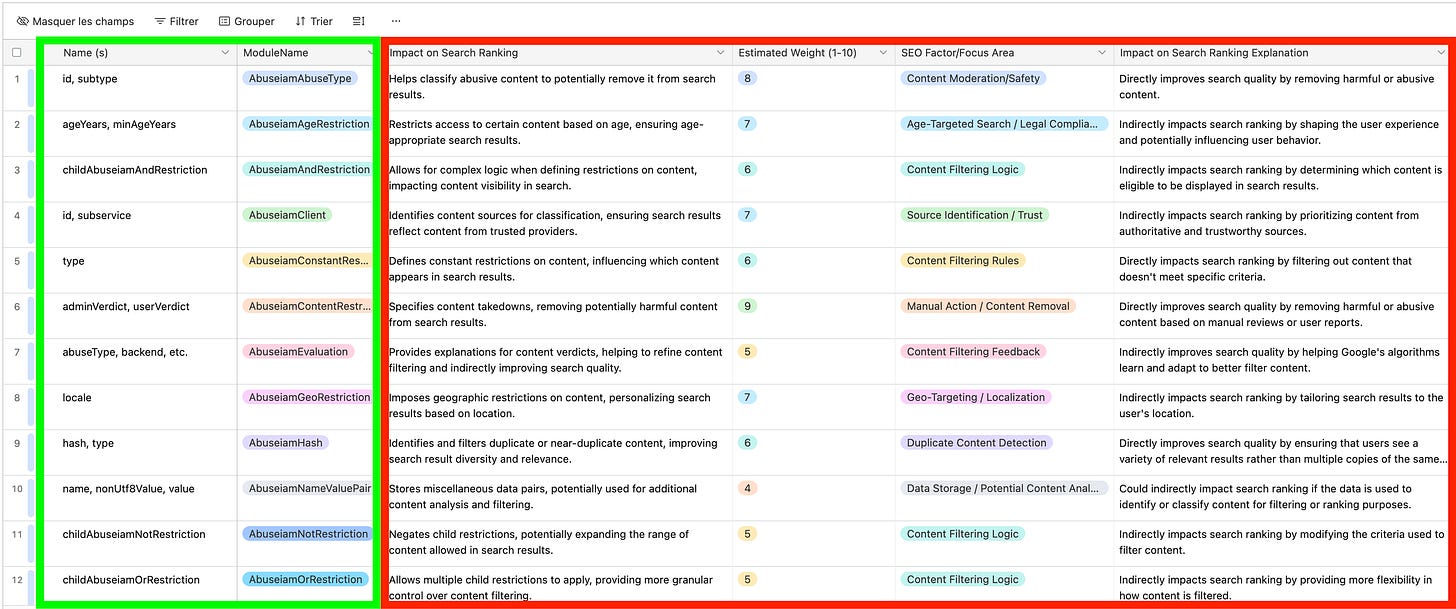

Par exemple, le tout nouveau site (et certainement pas le dernier) avec un nom éloquent https://searchrankingfactors.com/ s’est mis à répertorier tous les attributs dévoilés (sous les noms de facteurs de classement) dans un format de tableau, mais il n’y a que les 2 premières colonnes qui citent les documents d’origine.

Les 4 autres colonnes, dont Impact on Search Ranking, Estimated Weight, Explanation sont purement fortuites et subjectifs.

Même si le nom d’attribut est parlant et accompagné d’une description précise, on peut vite avoir envie de raisonner par induction et s’imaginer les choses qui ne sont pas dedans.

Prenons l’exemple de l’attribut hostAge:

hostAge (type: integer(), default: nil) - The earliest firstseen date of all pages in this host/domain. These data are used in twiddler to sandbox fresh spam in serving time. Selon la description, l’attribut est utilisé pour filtrer le spam récemment apparu, en créant une sandbox.

Est-ce que cela voudrait dire que tous les nouveaux sites passent par la sandbox ? Non, mais c’est un signal parmi les autres qui peut faire partie de l’algorithme anti-spam.

Je trouve, il est important de trouver un bon équilibre entre un scepticisme sain et un esprit de recherche ouvert.

Ainsi, lorsque je me penche sur ce document, je préfère adopter l'attitude suivante :

Voici une liste de ce que le moteur de recherche de Google peut prendre en compte. Ils y ont incontestablement réfléchis (parce qu’ont créé des attributs dédiés) certainement testé (sinon pourquoi faire ce travail inutile) et éventuellement déployé (à tester par soi-même).

GPT pour explorer Google Leak

Pour faciliter le travail avec les documents, j’ai créé ce GPT qui utilise l’ensemble des fichiers comme base de connaissances.

Il est en accès public, posez-lui vos questions pour avoir une réponse précise directement depuis la documentation.

L’avantage d’un GPT par rapport au moteur de Hexdocs (où les fichiers sont uploadés) est qu’on peut raisonner par gros blocs, par exemple:

liste d’attributs concernant les vidéos

quels scores sont évalués sur l’ensemble du site etc.

Il n’invente rien, juste cite les informations présentes dans les fichiers en les organisant, agrégeant d’une meilleure manière :

Comprendre l’étendue de ce qui peut être pris en compte par un moteur de recherche

Une des choses les impressionnantes que je note parcourant les documents, c’est l’étendue des aspects considérés par le moteur de recherche.

Si vous vous êtes déjà demandé si Google prenait en compte telle ou telle chose, la documentation montre que les ingénieurs y ont certainement réfléchi, voire testé.

Il y a quelques années, j’ai assisté à une conférence SEO lors de laquelle un speaker a énoncé une idée :

Comme l’objectif de Google est de rendre les gens heureux et qu’ils reviennent toujours sur Google, ils faut qu’ils vivent une expérience positive. N’avez-vous jamais vérifié si votre contenu émettait vraiment des sentiments positifs ?

A l’époque, j’ai trouvé cette idée curieuse, mais éloignée de la réalité. Mais quand je regarde les attributs dévoilés, j’en retrouve un bon nombre qui en parlent :

Evidemment, on ne sait pas exactement pour quel environnement de recherche ces attributs ont été conçus - pour le web, pour Youtube ou peut-être pour Maps - mais les ingénieurs de Google s’y ont certainement penché et ce n’est plus si fantastique que ça.

Un autre exemple :

Par le passé, j’ai travaillé sur d’autres marchés utilisant d’autres moteurs de recherche, dont Yandex. Un des indicateurs qu’on avait l’habitude de suivre était ce qu’on appelait “les clicks longs” (on utilisait les données de Yandex Metrica et comptait les sessions pour chaque page de >1 ou >3 minutes en fonction des sites).

Aujourd’hui, je les retrouve également parmi les attributs dévoilés de Google:

Quelques autres exemples d’attributs non-évidents ou curieux :

politeness - Le degré de politesse montré par l'utilisateur.

imageQualitySensitiveFaceSkinToneSignals - n'a pas de description dédiée, mais dans le document on trouve une mention de Skin Tone Twiddler qui assurerait la diversité des couleurs de peaux dans la recherche d'image. Probablement, lié à cela : https://blog.google/products/search/monk-skin-tone-scale/.

vlqNsr - NSR (Normalized Site Rating) pour les vidéos de basse qualité.

Cela contraste avec certaines tendances d’une vision simpliste du SEO.

Le moteur de recherche, surtout avec 26 ans d’histoire, est un château à des milliers des pièces Légo de toutes les couleurs et formes.

Signaux de qualité calculés sur l’ensemble du site

Souvent en travaillant le SEO on travaille au niveau des pages. Selon la nouvelle documentation, il y a un nombre important de scores qui sont attribué aux niveau du site, certains sont booléens (isVideoFocusedSite), certains en nombres continus (ymylNewsV2Score).

Une bonne partie est répertoriée sur cette page :

Site-level tofu score et chardEncoded - prédicteurs de qualité de l’ensemble site basé sur le contenu.

TitlematchScore - score au niveau du site qui indique dans quelle mesure les titres correspondent aux requêtes des utilisateurs.

localityScore - Score de localité du site, faisant partie du signal de l'Autorité Locale (LocalAuthority signal).

siteEmbedding - Embeddings compressés de site/page.

siteFocusScore - Nombre indiquant à quel point un site est centré sur un seul sujet.

Tisser les liens entre les attributs, brevets, documents du procès antitrust etc.

La fuite nous a ajouté une nouvelle source d’informations sur le fonctionnement du moteur de recherche. Et plus il y a de sources, mieux c’est!

Par exemple, on peut faire l’exercice de tisser des liens entre les attributs dévoilés et les brevets, souvent considérés comme détachés de l’implémentation réelle.

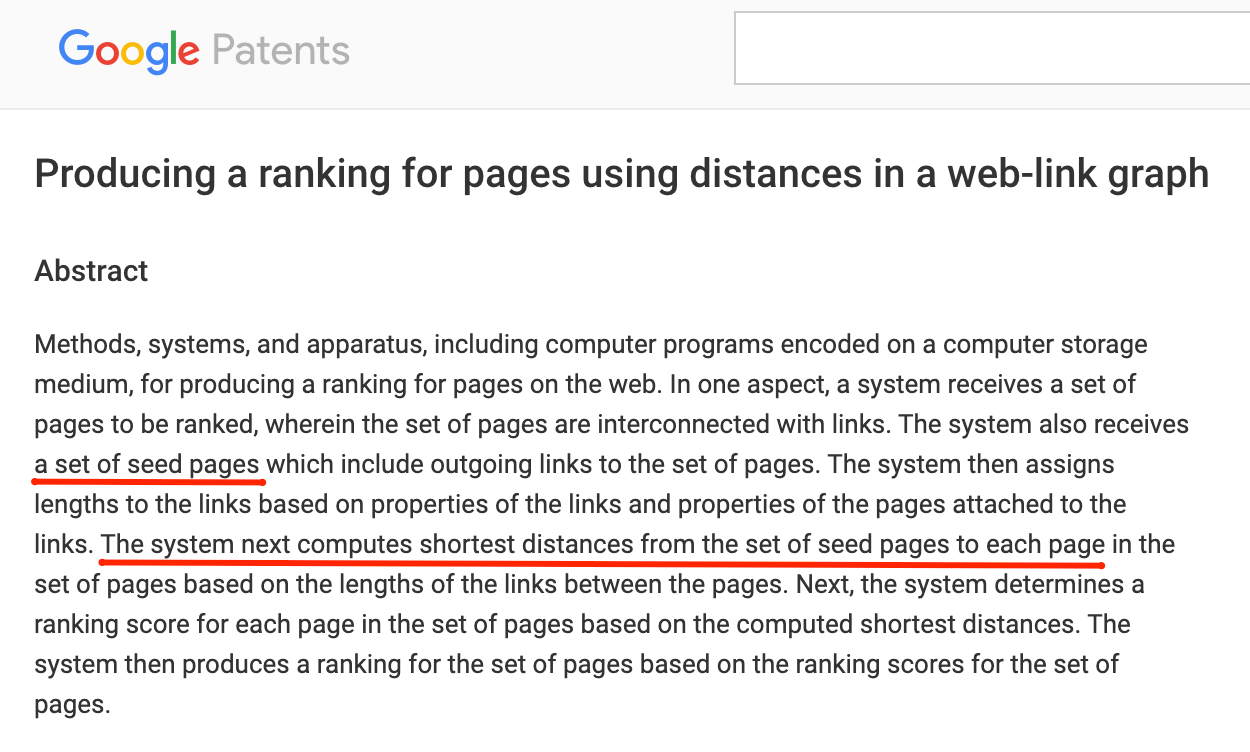

Prenons l’exemple du Pagerank.

On retrouve dans la documentation l’information que l’attribut Pagerank d’origine a été déprécié et replacé par celui d’un certain PagerankNS.

Il ne s’agit pas de quelque chose de nouveau, on retrouve l’explication du principe de Pagerank-NearestSeeds dans un brevet de Google datant de 2006 : Producing a ranking for pages using distances in a web-link graph.

Cela le rapproche d’un autre algorithme Trustrank de Stanford et Yahoo! (2004) qui commence par identifier un petit ensemble de pages jugées fiables, souvent manuellement sélectionnées.

Ensuite, TrustRank utilise un processus itératif similaire à celui du PageRank, où un score de confiance est propagé des pages de confiance à d'autres pages via leurs liens hypertextes. Plus une page est proche des pages de confiance de départ (en termes de liens), plus elle a de chances de recevoir un score élevé.

On peut également repréciser les informations découvertes lors de procès antitrust, comme Navboost -algorithme utilisant les clics des utilisateurs pour améliorer la pertinence des résultats de recherche.

Conclusion:

Je vois plusieurs intérêts pour prêter de l’attention aux documents issus de Google Leak:

On n’a jamais eu d’informations aussi précises sur ce que le moteur de recherche peut prendre en compte. En termes de crédibilité, ce leak cède évidemment aux informations qu’on a eues suite à la récente affaire antitrust du Cour de Justice américain (on ne ment pas devant un tribunal), mais gagne en termes de précision. Même s’il n’y a pas d’autant de détails qu’on souhaitait.

Même si beaucoup d’informations dévoilées ne font que confirmer ce qu’on savait/sentait/supposait déjà, c’est pour la 1ère fois qu’on voit la forme comment tout cela peut être structuré.

Le leak permet de tisser des liens entre les brevets, communications officielles de Google, informations découvertes lors du procès.

Source d’inspiration pour des tests et expérimentations SEO.

Source d’idées pour les outils SEO, notamment tout ce qui concerne le SEO prédictif, analyses sémantiques du contenu, graphes et entités etc. En travaillant beaucoup avec les embeddings et les entités, mon backlog s’est bien remplit 😍

Pour finir, voici quelques recommandations de bonnes lectures sur le sujet:

Tout sur les fuites de l’API de Google Search : une mine d’informations pour les SEO par Aurélien.

Comment exploiter la fuite de documents Google : idées et actions concrètes SEO par Olivier Duffez de WebRankInfo.

Leveraging Google’s Content Warehouse API for Structured Annotation, Semantic Analysis and Feature Tagging par Jeff Coyle de MarketMuse.

22 Things we might have learned from Google Search Leak par Matthew Woodward de Search Logistics.

A très vite !